L’IA e sicurezza sul lavoro rappresentano un binomio che sta già modificando gli scenari della prevenzione aziendale. L’impianto normativo nazionale, fondato sul Dlgs 81/2008, obbliga il datore di lavoro a valutare “tutti i rischi” per la salute e la sicurezza. Questo principio si scontra oggi con una nuova realtà tecnologica, ora disciplinata in modo specifico dal Regolamento Europeo (UE) 2024/1689, noto come “AI Act”.

Questa legislazione, già in vigore, classifica i sistemi di intelligenza artificiale in base al livello di pericolo, da “inaccettabile” a “minimo”. Molti sistemi di IA utilizzati nella gestione delle risorse umane (assunzione, valutazione, monitoraggio) e nella supervisione dei processi produttivi e della sicurezza stessa rientrano nella categoria ad “alto rischio”. Tale classificazione impone ai fornitori e agli stessi datori di lavoro che li utilizzano (deployer) obblighi stringenti di trasparenza, sorveglianza umana, robustezza e valutazione della conformità, rendendo di fatto obbligatorio un adeguamento dell’approccio tradizionale alla valutazione dei rischi.

L’impatto del Regolamento UE su IA e sicurezza sul lavoro

L’intelligenza artificiale non è solo un nuovo strumento di prevenzione, ma è essa stessa fonte di nuovi rischi specifici che il Dlgs 81/2008 non poteva prevedere nel dettaglio e che l’AI Act ora regolamenta. Questi pericoli emergenti possono essere classificati in diverse categorie. Emergono innanzitutto i rischi algoritmici, legati all’opacità di funzionamento di alcuni sistemi (la “black box”) e alla possibilità che gli algoritmi replichino o amplifichino bias e discriminazioni, con impatti diretti sulla salute psico-sociale dei lavoratori.

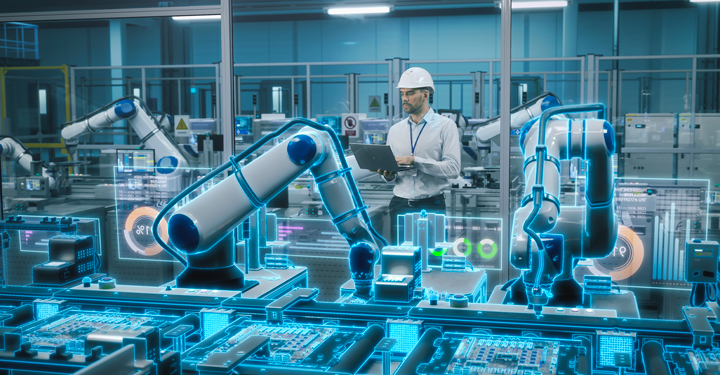

Si configurano poi nuovi rischi nell’interazione uomo-macchina, specialmente con robot collaborativi (cobot) o esoscheletri, che modificano la natura stessa del sovraccarico biomeccanico.

Infine, l’uso di IA per il monitoraggio digitale intensivo dei lavoratori genera nuovi rischi psico-sociali, come l’iper-controllo, l’ansia da prestazione algoritmica, l’isolamento e la de-responsabilizzazione.

Parallelamente, l’IA offre enormi opportunità per la prevenzione: sistemi predittivi capaci di analizzare dati e near-miss per anticipare gli infortuni, “computer vision” per monitorare in tempo reale il corretto uso dei dpi o l’accesso ad aree pericolose, e la creazione di ambienti formativi immersivi e personalizzati.

Aggiornamento del DVR e nuovi obblighi formativi

L’adozione di sistemi di intelligenza artificiale, specialmente quelli classificati ad alto rischio dall’AI Act, rende legalmente obbligatorio un aggiornamento del documento di valutazione dei rischi (DVR).

Il datore di lavoro, in adempimento sia al Dlgs 81/08 sia al nuovo regolamento, deve integrare nel DVR la valutazione di questi nuovi rischi algoritmici e psico-sociali, identificando le adeguate misure di prevenzione e protezione. Questa nuova valutazione richiede competenze multidisciplinari che coinvolgono non solo tecnici della sicurezza, ma anche esperti di data governance e privacy.

Di conseguenza, sorge un obbligo formativo specifico ai sensi dell’articolo 37 del Dlgs 81/08. Non è più sufficiente formare i lavoratori sul “come” si usa un nuovo software, ma è indispensabile informarli e formarli sui “rischi” connessi al suo utilizzo. I lavoratori, e i loro rappresentanti (RLS), devono comprendere i principi di funzionamento del sistema, i loro diritti (come il diritto alla spiegazione di una decisione automatica), i pericoli di un eccessivo affidamento (over-trust) all’algoritmo e le procedure da adottare in caso di malfunzionamento, garantendo che la supervisione umana rimanga sempre l’elemento centrale del sistema di sicurezza.